فایل robots.txt

فایل robots.txt چیست؟ robots.txt یکی از سادهترین فایلهای وبسایت است اما نحوه استفاده از آن حساسیت بالایی دارد. گاه استفاده از یک کاراکتر اشتباه در این فایل، میتواند موجب تخریب سئوی سایت شود. در واقع استفاده نامناسب از فایل robots.txt، از ایندکس شدن اطلاعات جلوگیری میکند و مانع دسترسی گوگل به محتوای مهم سایت شما میشود. در این مقاله شما را با نحوه استفاده از فایل robots txt و تاثیر آن بر سئوی سایت آشنا خواهیم کرد.

کاربرد فایل robots.txt چیست؟ و چه تاثیری بر سئوی سایت دارد؟ اولین چیزی که رباتهای موتورهای جستجو با آن برخورد میکنند، فایل Robots.txt است. با درج دستورات خاص در فایل Robots txt، میتوانید تعیین کنید که رباتهای موتور جستجو کدام صفحات، بخشهای سایت و فایلها را بررسی و ایندکس کنند و کدام صفحات را نادیده بگیرند. در واقع کاربرد فایل Robots txt برای معرفی بخشهای قابل دسترس و بخشهای محدود شده برای دسترسی خزندهها در سطح وب، بهمنظور بررسی و ثبت اطلاعات سایتها است. در واقع خزندهها برنامههایی هستند که در وب میخزند و موتورهای جستجو از آنها برای پیدا کردن محتوای وب برای ایندکس مطالب استفاده میکنند.

خزندهها قبل از هر چیز، دنبال فایل robots txt در دایرکتوری ریشه وب سایت میگردند. اگر این فایل وجود نداشته باشد، خزندهها آزادانه در وب سایت میخزند؛ اما در صورت وجود فایل robots txt، خزندهها بهدنبال دستورالعملها میگردند و موجب میشوند که خزیدن در وبسایت ادامه پیدا کند.

Robots.txt فایلی ساده و از نوع متنی است. با قرار دادن فایل robots.txt روی سرور سایت، میتوانید نحوه دسترسی رباتها به صفحات خود را کنترل کنید. این فایل تعیین میکند که کدام صفحات باید خزیده شوند و کدام صفحات نباید خزیده شوند. برای دسترسی به این اطلاعات، فایل باید در دایرکتوری ریشه وبسایت قرار گیرد. بهعنوان مثال اگر شما یک سایت فروشگاه ساز اینترنتی دارید و نام آن shopfa.com است، فایل robots.txt باید بهصورت shopfa.com/robots.txt برای بررسی خزندهها جهت ایندکس صفحات وارد شود.

نحوه استفاده از فایل robots txt

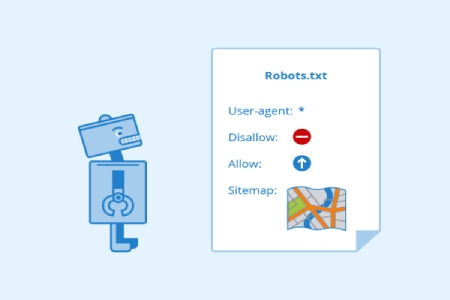

با دستورات پیشفرض و ادغام کلمات کلیدی، میتوان عملکرد فایل robots txt را از قبل تعیین کرد. از رایجترین دستورات میتوان به User-agent ، Disallow ، Allow ، Crawl-delay و Sitemap اشاره کرد. البته در اکثر مواقع نیازی به آموزش ساخت فایل robots txt در وردپرس یا یوست نیست. این ابزارها از طریق پلاگینها بهصورت مستقیم به فایل txt دسترسی دارند و میتوانند آن را ویرایش کنند. اما شما میتوانید به صورت دستی نیز فایل Robots.txt را ویرایش کنید. آشنایی با معانی و عملکرد این دستورات به شما کمک میکند تا درک درستی از تنظیمات اعمال شده در فایل متنی robots txt داشته باشید.

دستور User agent، تعیین میکند که رباتها و به کدام بخشهای سایت دسترسی داشته باشند و دسترسی آنها به کدام بخشها قطع شود. با این دستورالعمل میتوان دسترسی را برای همه رباتها آزاد کرد یا با نوشتن نام یک ربات، دسترسی یا محدودیت برای آن ربات خاص بهوجود آورد. اگر جلوی کد دستوری user agent یک ستاره بگذارید، (user-agent:*) یعنی همه بخشهای سایت برای بررسی رباتها و خزندگان موتورهای جستجو در دسترس است. اگر هم میخواهید که بهمنظور مدیریت محصولات سایت، اطلاعات برای ربات خاصی در دسترس باشد، باید به جای ستاره، نام دقیق ربات را وارد کنید.

با کمک دستور Allow و Disallow، میتوان به رباتهای تعیین شده در بخش user agent اعلام کرد که کدام بخشهای سایت را بررسی و ایندکس کنند. کد Allow بهمعنی اجازه دسترسی و Disallow به معنی محدودسازی دسترسی خزندهها به بخشهای مختلف سایت است. با استفاده از این کد دستوری میتوانید، مسیرها و صفحات مشخص شده سایت برای دسترسی رباتها را بهصورت موردی انتخاب کنید تا فقط این بخشها در دسترس یا از دسترس خارج باشند. برای مثال برای ساخت فایل robots txt در وردپرس، با نوشتن متن /Disallow: /wp-admin، مسیر ورودی رباتها برای دسترسی به پنل مدیریتی وردپرس محدود خواهد شد.

کد دیگری که بهمنظور کنترل خزندهها میتوان از آن استفاده کرد، Crawl-delay یا نرخ تاخیر است. با این دستورالعمل، رباتهای جستجو مجبور میشوند تا بررسی و ایندکس صفحات وبسایت را به نوبت و براساس زمانبندی شما انجام دهند. استفاده از این کد دستوری با هدف کاهش تعداد درخواستهای مکرر رباتها به سرور سایت انجام میشود. در نتیجه فرآیند ایندکس صفحات تسهیل خواهد شد.

البته به این نکته توجه داشته باشید که استفاده از کد دستوری Crawl-delay روی بعضی از رباتها از جمله Googlebot قابل استفاده نیست. برای فعال کردن این قابلیت در ربات گوگل، میتوانید از سرچ کنسول و مراجعه به بخش تنظیمات سایت، زمان بررسی صفحات را تغییر دهید. برای استفاده از این کد میتوانید در فایل متنی robots.txt بنویسید crawl-delay: 10. یعنی به موتورهای جستجو اعلام میکنید که مثلا بعد از ایندکس صفحه قیمت طراحی سایت فروشگاهی ، 10 ثانیه صبر کرده و بعد صفحه دیگری را ایندکس کنند. با تغییر عدد 10، میتوانید میزان مکث برای ایندکس هر صفحه را کم یا زیاد کنید.

تاثیر فایل robots.txt بر سئو سایت

مطمئن شوید که قبلا این فایل در سرور سایت شما ساخته نشده باشد. برای اطلاع از این موضوع عبارت /robots.txt را در انتهای آدرس سایت خود بنویسید و اینتر را بزنید. اگر به صفحهای وارد شدید که در آن کدهای دستوری مثل user agent یا allow را دیدید، یعنی برای سایت قبلا فایل robots txt ساخته شده است. اما اگر به صفحهای با ارور 404 هدایت شدید، یعنی قبلا فایل txt برای سایت شما ساخته نشده است.

برای ساخت فایل robots txt، فایل متنی را در notepad یا word بنویسید. سپس کدهای دستوری را در آن قرار داده و با نام robots ذخیره کنید. برای آپلود فایل از طریق FTP یا کنترل پنل هاست سایت، به قسمت مدیریت فایل بروید و فایل robots txt را در روت اصلی هاست آپلود کنید.

اگر فایل Robots txt با فرمت استاندارد تهیه نشود، امکان شناسایی دستورات آن وجود نخواهد داشت. در واقع در صورت آپلود نادرست فایل txt، رباتها به اطلاعات سایت شما دسترسی دارند و میتوانند آنها را ایندکس کنند. در واقع زمانی شاهد تغییر رفتار رباتها هستیم که دستورات دقیق را از طریق فایل متنی robots txt دریافت کنند. در غیر اینصورت همچنان به رفتار طبیعی و ایندکس کردن بخشهای سایت ادامه خواهند داد.

نحوه تنظیم فایل ROBOTS TXT روی سرور سایت

در این مقاله با فایل robots.txt آشنا شدیم و به این سوال پاسخ دادیم که فایل robots.txt چیست؟ این فایل متنی ساده، نقش مهمی در ایندکس شدن صفحات و نمایش محتوای مهم وب سایت در نتایج جستجو دارند. یک نکته مثبت در مورد فایل robots.txt این است که نیاز به صرف وقت زیاد و آزمون و خطای مداوم ندارد.

همچنین برای مدیریت راحتتر این فایل، میتوان از ابزار آنلاین گوگل سرچ کنسول استفاده کرد. توصیه ما این است که فایل کامل و نهایی robots txt را بعد از ساخت وب سایت تهیه کنید. فروشگاهساز شاپفا با کارشناسی دقیق، صفر تا صد راهاندازی سایت فروشگاهی را براساس نیازهای شما بر عهده خواهد گرفت. برای اطلاع از خدمات شاپفا میتوانید به سایت shopfa.com مراجعه کنید یا با شماره 02167954 تماس بگیرید.