«حمیدرضا مازندرانی»، پژوهشگر شبکه و هوش مصنوعی در یادداشت اختصاصی که برای دیجیاتو نوشته، تاریخچه، نقش پنهان و چالشهای یادگیری تقویتی در تکامل هوش مصنوعی را بررسی کرده است.

یادگیری تقویتی در چند دهه گذشته راه پرفرازونشیبی را پیموده است، راهی که امروز هموارتر و چشمنوازتر از گذشته به نظر میرسد. اما این راه به کدام سو میرود و چه مقصدی را میتوان انتظار داشت؟ یادداشت پیشرو نگاهی کوتاه به این پرسشها میاندازد.

یادگیری تقویتی، در پی تعامل با محیط و دریافت پاداشهای متناسب، پارامترهایش را اصلاح میکند. به بیان دیگر، دیتاست خودش را میسازد، بیآنکه نیازی ذاتی به دادههای آموزشی برچسبدار و آماده داشته باشد. این رویکرد بهعنوان مکمّلی برای یادگیری متداول در نظر گرفته میشود، بهویژه برای مسائلی از جنس تصمیمگیری که گاهی پاسخ درست در هر موقعیت از پیش معلوم نیست.

دو دانشمند به نام «ریچارد ساتن» و «اندرو بارتو» چارچوب علمی یادگیری تقویتی را، به آن شکلی که ما امروز میشناسیم، در اواخر دهه ۷۰ میلادی (۵۰ خورشیدی) بنا نهادند. البته ایدههای آن سالها قبل، یعنی اوایل قرن بیستم میلادی، از سوی روانشناسان ابداع شده بود. شاید نام آزمایش معروف «جعبه اسکینر» را شنیده باشید که در آن حیوانات یاد میگرفتند با فشار دادن اهرم، غذا دریافت کنند.

البته بعدها روانشناسان دریافتند یادگیری تقویتی مدلی بیشازحد ابتدایی برای توصیف رفتار انسانها و حتی حیوانات است. مثال معروفش پدیده «درماندگی آموختهشده» است که طبق آن موجودات زنده تحت شرایط مایوسکننده، تلاشی برای به حداکثر رساندن پاداش نمیکنند، آنچنان که یادگیری تقویتی انتظار دارد.

با این وجود، مانع اصلی یادگیری تقویتی در دنیای هوش مصنوعی از جنس دیگری بود: نیاز به تعاملات فراوان با محیط، تا اندکی بهتر از یک عامل تصادفی رفتار کند. اما در نیمهی دوم دهه گذشته میلادی، ترکیبی از پیشرفت سختافزاری، ظهور یادگیری عمیق و همچنین ارائه الگوریتمهای کارآمدتر، این مانع را تا حدی برطرف ساخت. در نتیجه، شرایط برای کمپانی دیپمایند فراهم گردید که قهرمانان شطرنج و بازی چینی Go را با مدلهای هوشمندش شکست دهد. این مدلها بر اساس میلیونها بازی با خودشان (تحت عنوان self-play) به این توانایی شگفتآور رسیده بودند.

حال همه شواهد حاکی از آن بود که یادگیری تقویتی ستاره آسمان هوش مصنوعی خواهد شد، اما داستان به گونه دیگری پیش رفت: مدلهای زبانی که بر اساس پیشبینی متن آموزش دیده بودند، انقلابی را شکل دادند که زندگی بشر را دگرگون ساخت. این روزها چتجیپیتی و رقبایش به بخشی جداییناپذیر از زندگی مردم سراسر جهان بدل گشتهاند و حتی صحبت از بهبود توانایی آنها در قالب «عاملیت هوشمند» میشود.

اما چه بر سر یادگیری تقویتی آمد؟ جالب اینجاست که بدانید یادگیری تقویتی نیز در تکامل مدلهای زبانی سهم اساسی داشته است. در واقع مشکل مدلهای زبانی اولیه این بود که چندان برای گفتگو با انسانها آماده نبودند. اما با آموزش همین مدلها در قالب یادگیری تقویتی و پاداشدهی به پاسخهای آنها، زمینه برای مدلهای سازگارتر با خواستههای کاربران فراهم شد.

در سال 2017، کمپانی دیپمایند، در همکاری پژوهشی با OpenAI (سازنده چتجیپیتی) روشی را بسط داد که زیربنای الگوریتم RLHF (یادگیری تقویتی با فیدبک انسانی) محسوب میشود. در الگوریتم مذکور، کاربران انسانی از بین دو پاسخ تولیدشده توسط مدل زبانی، گزینه سودمندتر و ایمنتر را برمیگزینند. با این انتخابها، یک مدل پاداشدهی آموزش داده میشود که مبنای آموزش مدل اصلی است. به نوعی میتوان گفت مدل پاداشدهی در نقش داور یا منتقد برای مدل زبانی عمل میکند.

با آن که RLHF یادگیری تقویتی بر روی مدل اصلی را مقیاسپذیر میسازد، اما دانشمندان قانع نشدند و ایدههای دیگری را توسعه دادند که اصلاً نیاز به کاربر انسانی نداشته باشد. نتیجه، ابداع روشهایی مثل RLVR (یادگیری تقویتی با پاداشهای قابل تأیید) بود که بر اساس پاسخ صحیح مسئله به مدل زبانی پاداش میدهد. پاسخ صحیح میتواند خروجی یک قطعه کد برنامهنویسی یا جواب نهایی یک مسئله ریاضی باشد. از این پس هر زمان که مدلتان در کدنویسی به شما کمک کرد، یادتان باشد که مدل نهفقط با پیشبینی متن، بلکه با تلاش برای یافتن پاسخهای صحیح مسائل کدنویسی به این توانایی رسیده است.

حال ممکن است وسوسه شویم که ادعا کنیم هوش مصنوعی انسانگونه یا فراتر از آن همین نزدیکی است، چرا که میتوان با دادن پاداشهای درست، مدلها را روز به روز قدرتمندتر ساخت. در سال 2021 چندین پژوهشگر (از جمله ریچارد ساتن) مقالهای با عنوان «پاداش کافی است» ارائه دادند که به نوعی همین خط فکری را دنبال میکرد. شاید از لحاظ تئوری چنین باشد، اما در عمل چالشهای جدی وجود دارد.

بسیاری از مسائل انسانی، همچون مشاوره مدیریتی، یا نوشتن چند خط شعر، پاداش قابل سنجشی ندارند. در پاسخ، عدهای به دنبال توسعه الگوریتمهای زیرمجموعه RLAIF (یادگیری تقویتی با پاداشهای هوش مصنوعی) هستند، که از هوش مصنوعی برای پاداشدهی به مدل زبانی استفاده میکند.

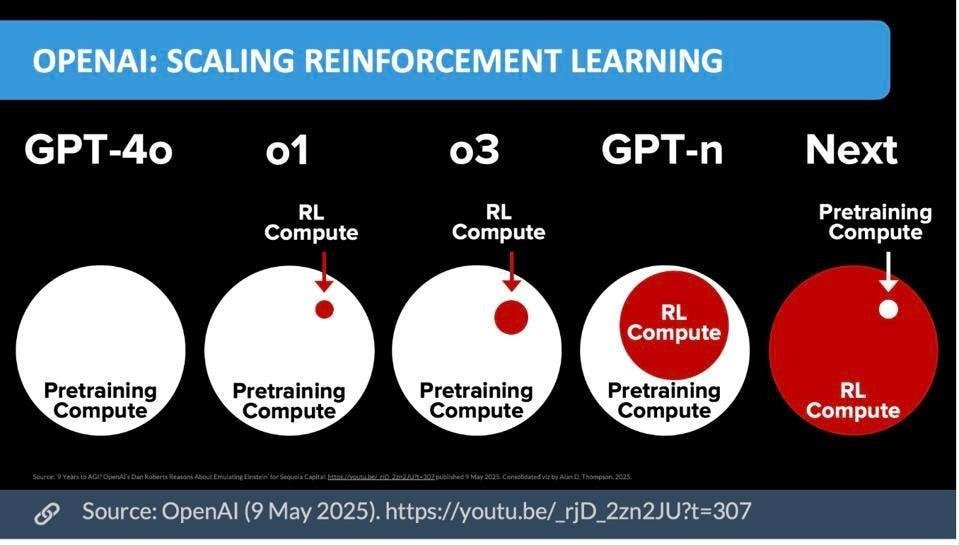

حتی اگر تلاشها به ساخت یک مدل جامع پاداشدهی بیانجامد که به مدل زبانی بگوید متنی که تولید کرده دقیقاً چقدر «خوب» است، مقیاسپذیری، همان مشکل قدیمی یادگیری تقویتی دوباره سر بر میآورد؛ به ویژه که مدلهای فعلی مجهز به «استدلال» شدهاند، به این معنی که چند بار خروجی تولید میکنند تا به خروجی نهایی برسند و این یعنی مصرف بیشتر منابع.

با این اوصاف، آیا یادگیری تقویتی ما را در نهایت به هوش مصنوعی جامع (AGI) خواهد رساند؟ این پرسش دشواری از چند جهت است. اول این که بسیاری باور دارند چیزی تحت عنوان «هوش مصنوعی جامع» نداریم. اگر هوش مصنوعی در سطح انسانی مدنظر است، همین حالا در برخی زمینهها انسان حرفی برای گفتن در مقابل هوش مصنوعی ندارد. اگر منظور رسیدن به همگونی و تعادل در بین مهارتهاست، کدام مهارتها و با چه معیاری؟ پس تا مقصد به طور دقیق مشخص نباشد، سنجیدن فاصله با آن بیمعناست.

چالش دیگر آن است که فرآیند پژوهش و توسعه به صورت تکاملی و بدون یک مغز متفکر واحد به پیش میرود. کمپانی دیپمایند پس از ظهور مدلهای زبانی مورد انتقاد قرار گرفته بود که روی یادگیری تقویتی قمار کرده است؛ و چه بسا اگر تاریخ تکرار میشد هرگز روی این حوزه سرمایهگذاری نمیکرد و ما از پیشرفتهای آن محروم میماندیم. بنابراین این مسئله که چه راهی باید پیموده شود، بسیار به تصمیمهای پژوهشگران و سرمایهگذاران و نه قابلیتهای ذاتی فناوریها بستگی دارد!

در نهایت نباید از خاطر برد که پژوهش همواره این توانایی را دارد که ما را غافلگیر سازد و چه بسا فناوری جدیدی ظهور کند، یا یک ایده قدیمی دوباره جان تازهای پیدا کند و یادگیری تقویتی را کنار بگذارد (یا بهتر، آن را تقویت سازد!).